Mobil robotok szimulációja speci 6. óra

Önszerveződés

- tanulás más formája

- példák mindenféle tanítás nélkül

- a bemenet belső struktúráját kell felfedezni

- osztályozás, kluszterezés, dimenziószám-csökkentés,

tulajdonság-kiemelés

- csillagászat, képi megjelenítés

Csoportosítás

- mindennapi élet gyakori feladata

- csoportokba rendezése, csoportokon belül nagy hasonlóság,

a csoportok között kis hasonlóság

- hierarchikus klaszter analízis: osztályok folytonos összevonása

- k-várható érték módszere: Gauss eloszlások paramétereinek becslése

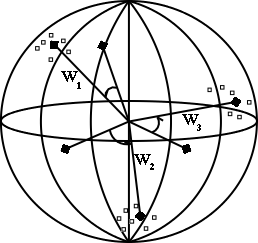

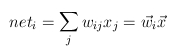

- teljes összekötöttségű, kétrétegű háló

- a bemeneti réteg az adatok dimenziója, a kimeneti réteg

a csoportok száma

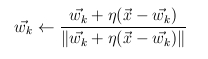

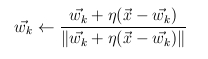

- hálósúlyok módosítása

- kezdeti véletlen súlyok

- hálódinamika

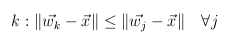

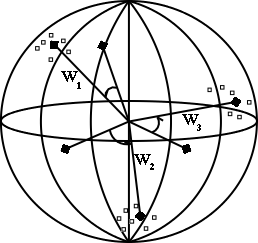

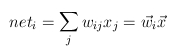

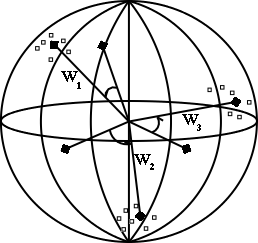

- egységvektorok

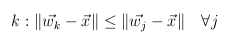

- maximum

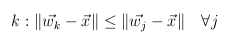

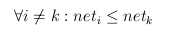

- a kimenet: a legnagyobb 1, a többi 0 (versenyzés)

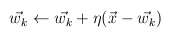

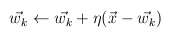

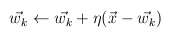

- tanulás során egyedül a győztes neuron súlyai változnak

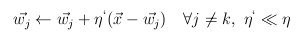

- súlyvektor elforgatása a példa irányába

- csoportosítás:súlyvektorok a térnek azon részei felé fordulnak el,

ahol sok a példavektor

- súlyvektor, mint osztálycímke

- maximumkeresés nem lokális feladat, neurális hálóval másképp kell megoldani

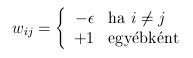

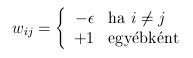

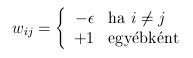

- MAXNET

- teljes összekötöttség, fix súlyokkal

- minden neuron kimenete 0-hoz konvergál, kivéve a legnagyobbé

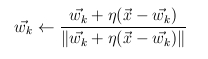

- normalizálás nélkül: egy a példával kis szöget bezáró,

de hosszú súlyvektor példával való szorzata nagyobb lenne, mint egy

kis abszolút értékű, de közeli súlyvektoré

- általánosabb megoldás

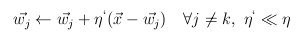

- súlyok módosítása e szerint

- távolságfüggvény és bemenet választásának fontossága

- mozdulatlan súlyvektorok elkerülése

- sok neuron, magas dimenziószám: súlyvektor sohasem lesz győztes

- súlyvektorok egyenletes inicializálása

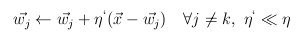

- szivárgásos tanulás

- frekvencia-érzékeny tanulás

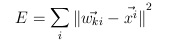

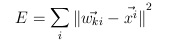

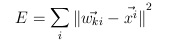

- megállás kérdése, hibafüggvény szerepe

Kohonen-féle tulajdonságtérkép

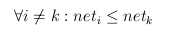

- winner-take-all <-> lágy versenyzés

- Kohonen eredménye a nyolcvanas évekből

- háló struktúrája megfelel a csoportosításnál látottaknak

- győztes kiválasztása sem tér el

- azonban van egy szomszédsági reláció

- bármilyen kapcsolati forma: négyzetháló, lánc, kör,...

- szomszédsági reláció != háló kapcsolatai

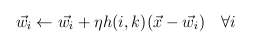

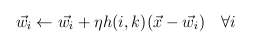

- tanulás új szabálya

- h győztes és az éppen vizsgált neuron közötti kapcsolat függvénye

- h nagyjából tetszőleges, h(k,k) = 1

- ha h mindenütt 0, akkor a csoportosításhoz jutunk vissza

- négy, nyolc szomszédság síkban, hat, huszonhat szomszédság térben

- Gauss függvény: jobb mozgás, kevesebb mozdulatlan neuron, de

hátrány nagyobb számításigény

- időben csökkenő szomszédság

- az idő előrehaladtával a háló mintegy kifeszíti a négyzet területét

- tér diszkrétizációja

- láthatóvá teszi a példák terének struktúráját

- navigáció

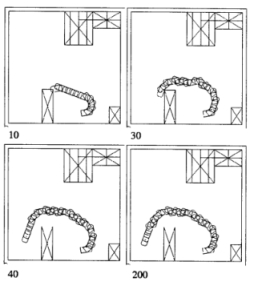

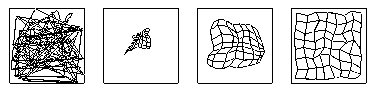

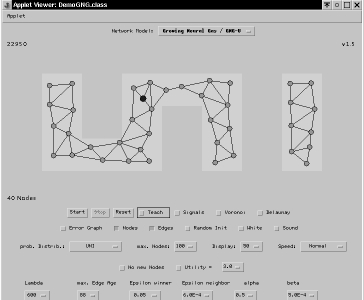

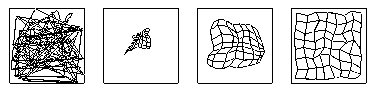

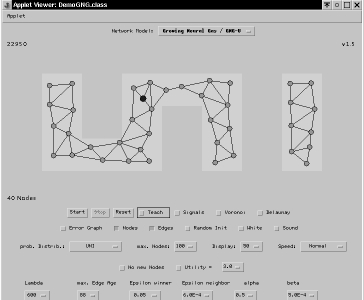

Önszerveződési eljárások demonstrációja

- Internetről letölthető programok, demok

- Loos és Fritzke DemoGNG programja

- alaptípusok és újak is

- neurális gáz: időben csökkenő szomszédság

- növekvő neurális gáz: egyre több neuron közelít

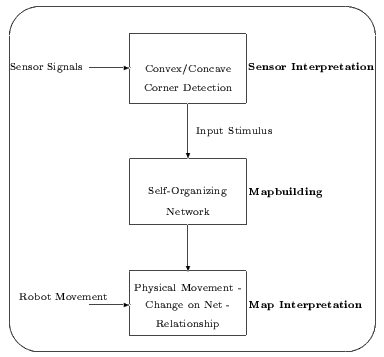

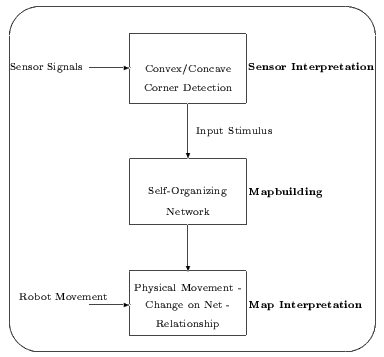

Önszerveződés robotszimulációban

- Nehmzow és Smithers, 1990 a Kohonen-féle önszerveződő

tulajdonságtérkép egy robot navigációjához

- külvilág belső reprezentációja

- három fő modul

- térkép bijekció a lehetséges állapotok teréből a térkép terébe

- nem csak felülnézeti térkép, hanem telefonkönyv vagy a családfa is lehet

- hasonlít a csoportosításnál bemutatott első változathoz (normálás)

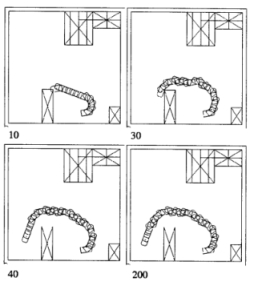

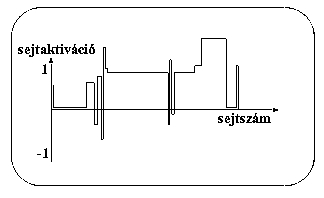

- 50 neuronból álló hálózat, gyűrű

- egydimenziós szomszédsági reláció

- a győztes súlymódosulásában két-két szomszédja osztozhat

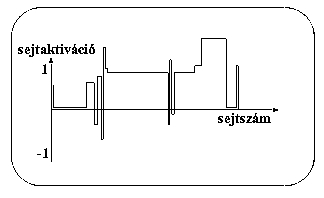

- a kimenet nem lesz binárissá alakítva

- helyek meghatározása nem a győztes neuronhoz rendelt pozíció alapján történik

- 50 neuron által alkotott összetett válasz egyedisége a pozíció címe

- a cím egyediségéhez a példáknak megfelelően kell reprezentálnia a külvilágot

- először akadálykikerülés és véletlen mozgás

- példák a szenzorok értékei és két akadállyal való találkozás közben megtett távolság

- csukott szemmel sétálásból térkép

- falkövetés

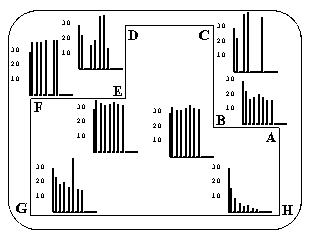

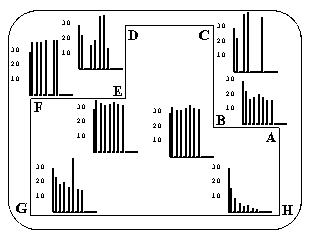

- első modul: sarok konvex vagy konkáv

- példa: az aktuális és a megelőző sarok irányultsága és távolsága

- az eljárás az ismert formában zajlik

- robot a fal mellett több kört megtesz

- sarkonként példa keletkezett

- a kezdetben nagy eta minden lépésben 5 százaléknyit csökken

- három kör után sarokkijelölés

- ezután különbségnorma számítása minden sarokra

- megfelelő belső reprezentációt -> jelöltnél kisebb norma, mint máshol

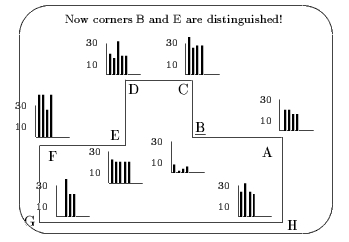

- H sarok felismerése

- C és F, valamint B és E problémás

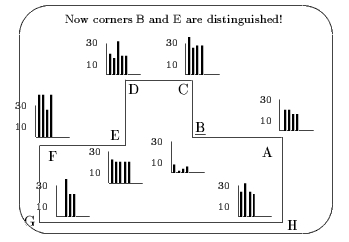

- példák kibővítése két sarokra nem elég (B és E)

- még mindig kevés

- példák kibővítése három sarokra már elég (B és E)

- előre meghatározott mozgás, de működő térkép, robusztus viselkedés

Megerősítéses tanulás

- tanulás más formája

- hétköznapjaink szerves része

- járás, kockatorony építése, vezetés, bioreaktor

- nincs tanító, a környezet reakcióiból következik a tevékenység jó vagy

rossz eredménye

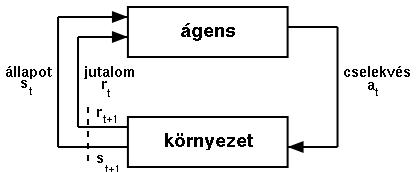

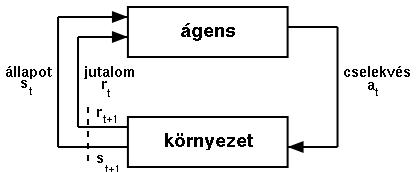

- meghatározott környezet, cselekvések

- diszkrét idő

- környezet cselekvésektől megváltozik, új állapot

- cselekvésért járó jutalom

- megerősítéses tanulás struktúrája

- döntési függvény: adott állapotban, adott cselekvés

végrehajtásának valószínűsége

- tanulás a döntési függvény módosításának folyamata

- szemétgyűjtő robot példája

- döntés haladási irány, állapot: robot és szemét helye, akku

- általában nincs jutalom, csak szemét felszedésekor, büntetés

lemerült akkunál

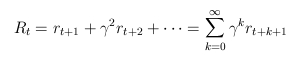

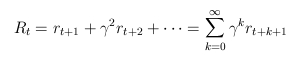

- nem szimplán a legnagyobb jutalom kiválasztása, hanem legnagyobb várható nyereség

- véges és végtelen eset

- felfedezés, kiaknázás dilemmája (exploráció-exploitáció)

Kiértékelő függvények

- a döntési függvény (pi) közvetlen megadása általában

nem lehetséges,

a megoldáshoz további függvények bevezetése szükséges

- Markov tulajdonság: nem kell korábbi állapotokhoz

visszanyúlni a helyzet megismeréséhez (sakkállás)

- és véges az állapotok és a cselekvések halmaza

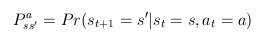

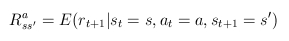

- akkor a teljes feladat-specifikáció az alábbi két egyenletrendszer

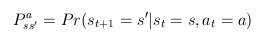

- átmenet valószínűségek

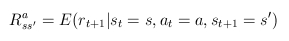

- várható jutalom

- az egyenletek nincsenek mindig a tanuló birtokában, de megismerhetőek.

- teljes feladat-specifikáció esetén sem könnyű a megoldás (sakk,

Rubik-kocka)

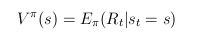

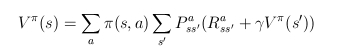

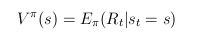

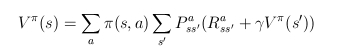

- állapotérték-függvény: mennyire értékes az adott állapot

a feladat szempontjából, az aktuális pi szerint

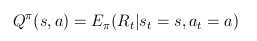

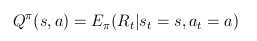

- akcióérték-függvény:mennyire értékes az adott állapotban az adott

cselekvés a feladat szempontjából, az aktuális pi szerint

- leggyakrabban ezeken és a döntési függvényen dolgozik a tanulás

- tanulás: értékfüggvények közelítése -> döntési függvény számítása

-> értékfüggvények növekedése -> ...

- optimális döntési függvény: minden állapotban a legjobb cselekvést választja

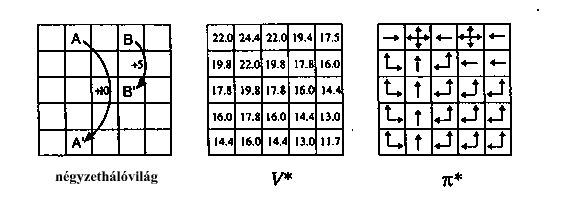

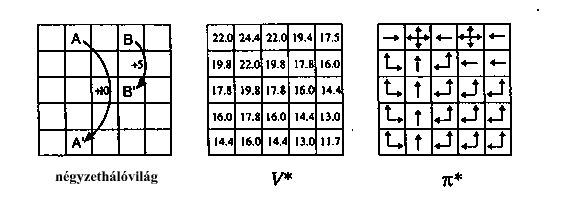

- négyzetháló-világban optimális állapotérték-függvény és optimális

döntési függvény

Megoldási módszerek

- dinamikus programozás

- teljes feladat-specifikáció ismert

- értékfüggvény rekurzív kiszámítása Bellman-egyenlőség alapján

- döntési függvény mohó módosítása állapotérték-függvény

szerint

- iteráció konvergenciáig

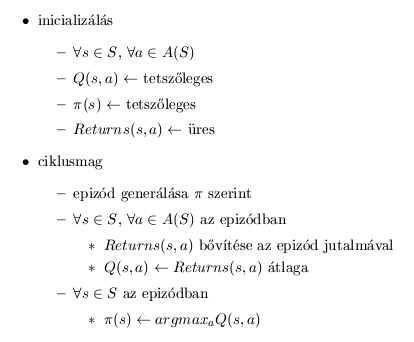

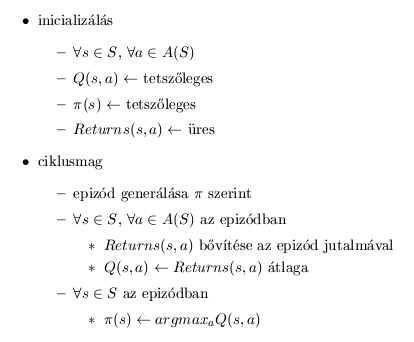

- Monte-Carlo módszerek

- nem ismert feladat-specifikáció

- a tanuló epizódokat gyárt

- jutalmak átlaga az érintett állapotokra és cselekvésekre meghatározott

akcióérték-függvény

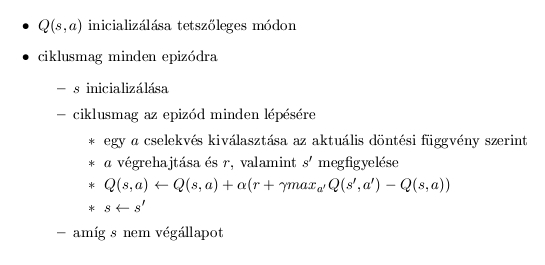

- algoritmusa

- időbeli differenciák

- Monte-Carlo modellnélkülisége

- értékfüggvény rekurzív előállítása, nem kell az epizódokat végigvárni

- konvergencia: korlátos jutalom, minden állapot-cselekvés páros tetszőlegesen sokszor legyen kiválasztva

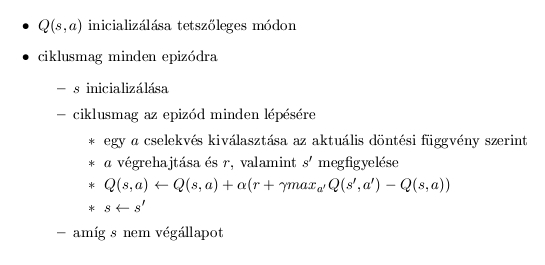

- Q-tanulás

- egyéb módszerek: megbízhatósági nyomok, függvényapproximáció

neurális hálóval

Megerősítéses tanulás Java nyelven

Navigáció megerősítéses tanulása

- megerősítéses tanulás jól használható, ha idő és a tér is diszkrét módon definiált

- robotikában nem ez a helyzet: folytonos tér, végtelen sok állapot

és cselekvés

- térdiszkrétizáció önszerveződéssel

- B. Kröse és M. Eecen munkája: Kohonen-térképre épített dinamikus programozás

- 16 távolságszenzor + iránytű

- térkép a szenzortérben van, mégis a valós világ pontjait reprezentálják

- Kohonen szomszédság elemei nem feltétlenül fizikailag közvetlenül

elérhető pontokat kötnek össze

- a szomszédsági relációk helyett a dinamikus programozás

hozza létre az állapotátmenetekhez szükséges cselekvések döntési

függvényét

- átmenetek valószínűségének meghatározása a robot szabadon közlekedésével

- közvetlen jutalom: a távolság és a tárgyaknak való ütközések

függvényében jön létre

- teljesen specifikáltság -> dinamikus programozás

- egy önszerveződés során előálló térkép

- a robot navigációja